مقاييس دقة الترجمة: شرح مفصل

تساعد مقاييس دقة الترجمة في تقييم مدى توافق الترجمات الآلية مع المراجع التي أنشأها الإنسان. هذه الأدوات حاسمة لتقييم جودة الترجمة، خاصة عند التعامل مع مشاريع واسعة النطاق أو محتوى حساس. تنقسم المقاييس إلى ثلاث فئات:

- مقاييس قائمة على النصوص: BLEU وMETEOR وTER تركز على تداخل الكلمات أو الأحرف.

- مقاييس قائمة على الشبكات العصبية: COMET وBERTScore تحلل التشابه الدلالي باستخدام نماذج الذكاء الاصطناعي.

- التقييمات البشرية: التقييمات المباشرة مثل MQM تركز على الكفاية والطلاقة.

النقاط الرئيسية:

- BLEU: سريع وبسيط لكنه يواجه صعوبات مع المرادفات والمعاني الأعمق.

- METEOR: يأخذ في الاعتبار المرادفات والفروق اللغوية؛ أفضل للأعمال الأدبية.

- TER: يقيس جهد التحرير لكنه يتجاهل الجودة الدلالية.

- COMET و BERTScore: نماذج ذكاء اصطناعي متقدمة تتوافق بشكل وثيق مع حكم الإنسان، رائعة للنصوص الدقيقة.

بالنسبة لترجمات الكتب، يضمن الجمع بين الأدوات الآلية والتقييمات البشرية الدقة والحفاظ على الأسلوب الأصلي. تستخدم منصات مثل BookTranslator.ai هذا النهج الهجين لتقديم نتائج موثوقة في أكثر من 99 لغة.

مقاييس دقة الترجمة الشائعة

درجة BLEU

تم تقديمه في عام 2002، يظل BLEU (مساعد التقييم الثنائي اللغة) مقياسًا موثوقًا لتقييم الترجمة الآلية [4]. يعمل من خلال مقارنة دقة n-gram، مما يعني تحليل كيفية توافق تسلسلات الكلمات في مخرجات الآلة مع الترجمات المرجعية. تتراوح درجات BLEU من 0 إلى 1، حيث تشير الأرقام الأعلى إلى جودة أفضل. أكبر نقاط قوتها؟ السرعة والبساطة - يمكن لـ BLEU معالجة آلاف الترجمات بسرعة، مما يجعلها عملية جدًا. حتى أن هذه الكفاءة حصلت على جائزة NAACL 2018 Test-of-Time.

كما أوضح Papineni وآخرون، "الفكرة الأساسية هي استخدام متوسط مرجح لمطابقات n-gram بأطوال متغيرة بين ترجمة النظام ومجموعة من الترجمات المرجعية البشرية" [4].

ومع ذلك، فإن BLEU لديه قيد ملحوظ: إنه يعطي الأولوية للمطابقات الدقيقة للكلمات. هذا يعني أنه قد يقلل من قيمة الترجمات التي تنقل نفس المعنى لكن باستخدام صياغة مختلفة. لمعالجة هذا، تهدف مقاييس مثل METEOR إلى التقاط الفروق اللغوية.

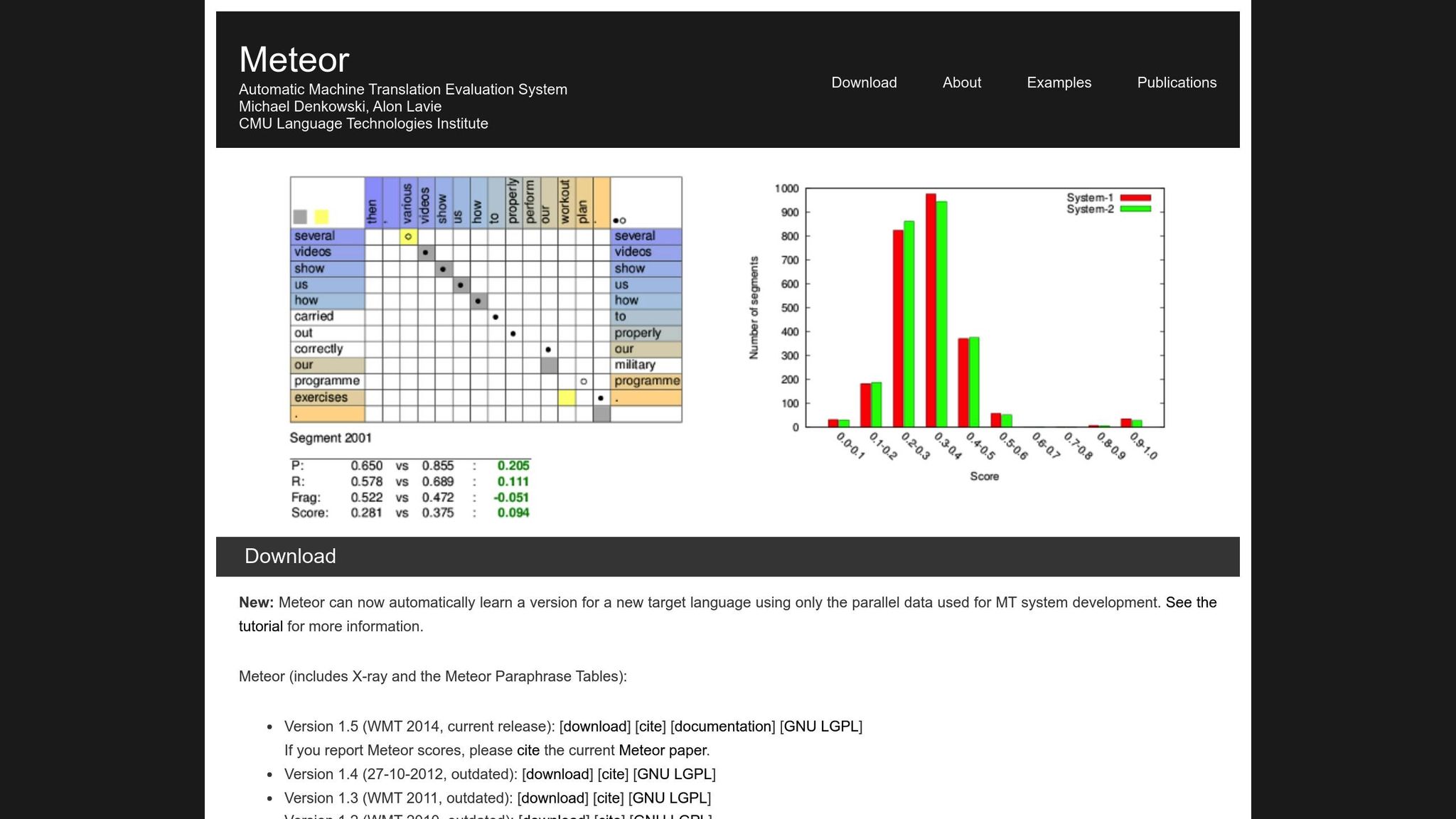

مقياس METEOR

يحسن METEOR (مقياس تقييم الترجمة مع الترتيب الصريح) من BLEU بأخذ الدقة والاستدعاء والمرادفات والجذور والعقوبات على ترتيب الكلمات في الاعتبار [1]. يتعامل مع الاختلافات مثل "running" مقابل "ran" أو "happy" مقابل "joyful"، مما يجعله أكثر ملاءمة للترجمات حيث يكون المعنى هو الأهم. على سبيل المثال، أثناء تحدي NIST MetricsMaTr10، حققت METEOR‑next‑rank ارتباط Spearman's rho بنسبة 0.92 مع أحكام الإنسان على مستوى النظام و 0.84 على مستوى المستند [1].

ومع ذلك، يأتي METEOR مع تحدياته الخاصة. يتطلب موارد إضافية، مثل قواعس بيانات المرادفات وخوارزميات الجذور، مما يضيف إلى حمله الحسابي. ومع ذلك، فإنه غالبًا ما يوفر تقييمًا أكثر دقة وموثوقية، خاصة لالتقاط الدقة الدلالية.

معدل تحرير الترجمة (TER)

يقيّم TER جودة الترجمة بحساب عدد التعديلات - الإدراجات والحذف والاستبدالات والتحولات - المطلوبة لتحويل مخرجات الآلة إلى المرجع. هذا يجعله مفيدًا بشكل خاص لقياس جهد التحرير المطلوب لمحاذاة المخرجات مع النتيجة المرغوبة. في تقييمات MetricsMaTr10، أظهرت TER-v0.7.25 ارتباطًا على مستوى النظام بنسبة 0.89 مع تقييمات الإنسان للكفاية الدلالية، بينما أظهرت TERp ارتباطًا على مستوى المقطع بنسبة 0.68 [1].

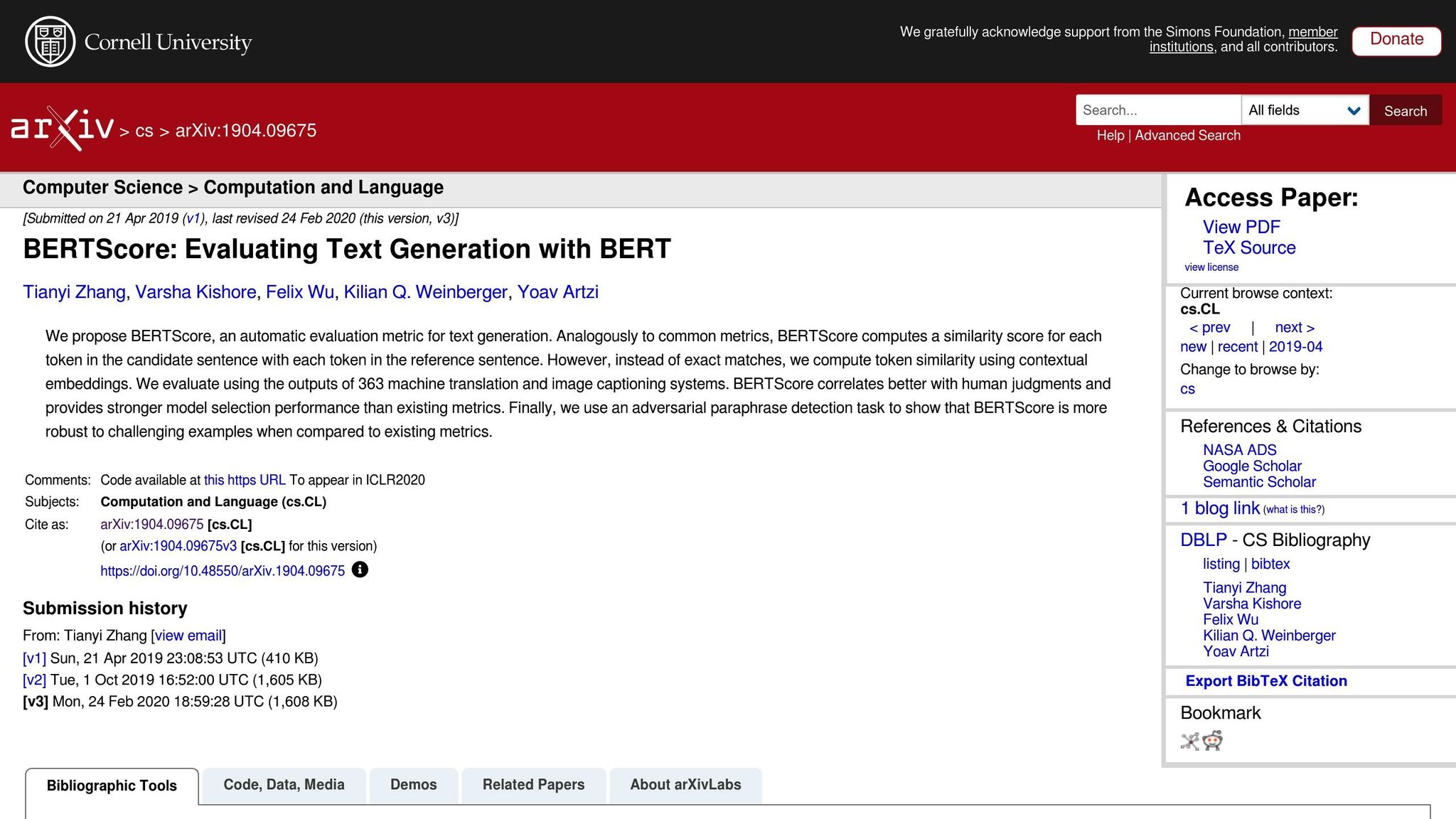

المقاييس القائمة على الشبكات العصبية: BERTScore وCOMET وGEMBA

تأخذ المقاييس القائمة على الشبكات العصبية تقييم الترجمة إلى المستوى التالي من خلال التركيز على التحليل الدلالي بدلاً من المطابقات الدقيقة للكلمات. إليك ملخص سريع:

- BERTScore: يستخدم التضمينات السياقية لقياس التشابه بين الترجمات.

- COMET: يدمج النص المصدر والفرضية والترجمات المرجعية في إطار عمل عصبي مدرب على التعليقات البشرية. لقد حقق بعض أعلى الارتباطات مع أحكام جودة الإنسان [5].

- GEMBA: يستفيد من نماذج اللغة الكبيرة لتقدير الجودة بدون تدريب، مما يوفر تقريبًا أقرب لتقييم الإنسان.

بينما تتمتع هذه المقاييس بقوة، فإنها تأتي مع مقابلات. على عكس BLEU و TER، التي يمكنها العمل على وحدات المعالجة المركزية القياسية في ميلي ثانية، غالبًا ما تتطلب المقاييس القائمة على الشبكات العصبية مثل BERTScore و COMET تسريع GPU للتعامل مع مجموعات البيانات الكبيرة بكفاءة. GEMBA بشكل خاص قد ينطوي على تكاليف API عالية والانحيازات المحتملة من نماذج اللغة الكبيرة، مما يجعلها أقل سهولة في الوصول لبعض المستخدمين.

المقاييس الآلية لتقييم أنظمة الترجمة الآلية

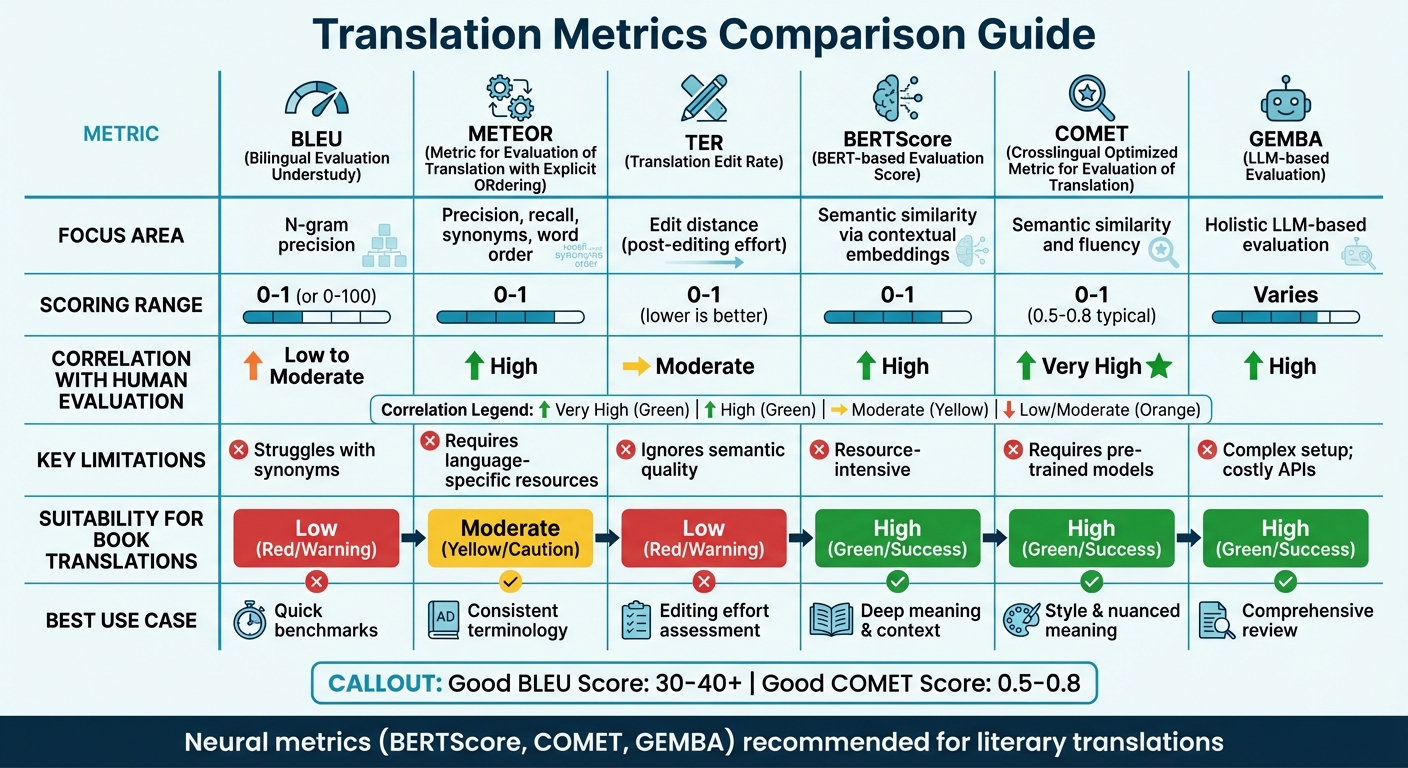

مقارنة مقاييس الترجمة

مقارنة مقاييس دقة الترجمة: BLEU و METEOR و TER و BERTScore و COMET و GEMBA

جدول مقارنة المقاييس

يعتمد اختيار مقياس الترجمة الصحيح غالبًا على التركيز على تقييمك والموارد المتاحة. المقاييس التقليدية مثل BLEU سريعة وتتطلب موارد قليلة لكنها تكافح لالتقاط المعنى الدلالي الأعمق. من ناحية أخرى، تتفوق المقاييس العصبية في فهم السياق والمعنى لكنها تتطلب قوة حسابية أكثر.

تشير الأبحاث الحديثة إلى الابتعاد عن المقاييس القائمة على التداخل. على سبيل المثال، توصيات WMT22 توصي بالتخلي عن مقاييس مثل BLEU لصالح النهج العصبي [6]. تبرز الدراسة أن المقاييس المتداخلة مثل BLEU و spBLEU و chrF ترتبط بشكل سيء مع تقييمات الخبراء البشريين.

إليك مقارنة سريعة لمقاييس الترجمة الرئيسية، تغطي مجالات تركيزها وطرق التسجيل والارتباط بتقييم الإنسان والقيود والملاءمة لترجمات الكتب:

| المقياس | مجال التركيز | نطاق التسجيل | الارتباط بتقييم الإنسان | القيود | الملاءمة لترجمات الكتب |

|---|---|---|---|---|---|

| BLEU | دقة N-gram | 0 إلى 1 (أو 0-100) | منخفض إلى معتدل | يكافح مع المرادفات [7][8] | منخفضة؛ تفتقر القدرة على التقاط الأسلوب الأدبي |

| METEOR | الدقة والاستدعاء والمرادفات وترتيب الكلمات | 0 إلى 1 | عالي | يتطلب موارد خاصة باللغة [7] | معتدلة؛ مفيدة للمصطلحات المتسقة |

| TER | مسافة التحرير (جهد ما بعد التحرير) | 0 إلى 1 (الأقل أفضل) | معتدل | يتجاهل الجودة الدلالية [7] | منخفضة؛ تركز على الميكانيكا، وليس "الصوت" |

| BERTScore | التشابه الدلالي عبر التضمينات السياقية | 0 إلى 1 | عالي | كثيفة الموارد [7] | عالية؛ تلتقط المعنى الأعمق والسياق |

| COMET | التشابه الدلالي والطلاقة | 0 إلى 1 (0.5-0.8 نموذجي) | عالي جدًا | يتطلب نماذج مدربة مسبقًا [7][8] | عالية؛ تحافظ على الأسلوب والمعنى الدقيق |

| GEMBA | التقييم الشامل القائم على نموذج اللغة الكبيرة | يختلف | عالي | إعداد معقد؛ واجهات برمجية باهظة الثمن [7] | عالية؛ توفر مراجعة شاملة "تشبه الإنسان" |

يوضح هذا الجدول كيف تتوافق المقاييس المختلفة مع احتياجات الترجمة المحددة. بالنسبة للترجمات التقنية، توفر مقاييس مثل BLEU و TER معايير أساسية سريعة وأساسية. ومع ذلك، بالنسبة للترجمات الأدبية - حيث يكون الأسلوب والنبرة والمعنى الدقيق حاسمًا - تؤدي المقاييس العصبية مثل BERTScore و COMET بشكل أفضل بكثير. هذه الأدوات ماهرة بشكل خاص في التقاط عمق وفن النصوص الأدبية، التي غالبًا ما تتجاهلها المقاييس التقليدية [7].

على سبيل المثال، تستفيد منصات مثل BookTranslator.ai، التي تهدف إلى موازنة الكفاءة والجودة، بشكل كبير من المقاييس العصبية. تضمن أدوات مثل BERTScore و COMET الحفاظ على الدقة الدلالية والأسلوب الأدبي معًا.

لوضع الأمور في منظورها، عادة ما تقع درجة "جيدة" من BLEU بين 30 و 40، مع درجات فوق 40 تعتبر قوية، وأي شيء فوق 50 يشير إلى ترجمة عالية الجودة [8]. بالنسبة لـ COMET، تتراوح الدرجات عمومًا من 0.5 إلى 0.8، مع القيم الأقرب إلى 1.0 التي تعكس جودة ترجمة قريبة من الإنسان [8]. لا تؤدي المقاييس العصبية بشكل ثابت عبر أنواع نصوص مختلفة فحسب، بل تتكيف أيضًا بشكل أفضل مع السياقات المختلفة مقارنة بالمقاييس الحساسة للمجال مثل BLEU [6].

sbb-itb-0c0385d

طرق التقييم البشري

قد توفر المقاييس الآلية السرعة والاتساق، لكنها غالبًا ما تفتقد التفاصيل الدقيقة التي تحدد جودة الترجمة. هنا يأتي دور التقييم البشري كمعيار ذهبي[2]. على الرغم من أنه أبطأ وأكثر تكلفة، فإن التقييم البشري يكشف عن الأسباب الأعمق وراء مشاكل الجودة - الأشياء التي لا يمكن لمقاييس مثل BLEU أو COMET تحديدها ببساطة[9].

هناك منهجان رئيسيان للتقييم البشري. أحدهما هو الحكم المعبر عنه بشكل مباشر (DEJ)، حيث يتم تقييم الترجمات على مقاييس مثل الطلاقة والكفاية. والآخر يتضمن طرق غير DEJ، التي تركز على اكتشاف وتصنيف أخطاء محددة، غالبًا باستخدام إطر عمل مثل MQM[12]. بينما تقسم الطرق التحليلية الأخطاء الفردية وشدتها، تنظر الطرق الشاملة إلى الجودة الإجمالية. معًا، تشكل هذه الأساليب العمود الفقري لأطر العمل مثل MQM.

MQM (مقاييس الجودة متعددة الأبعاد)

عندما تقصر الأدوات الآلية، يوفر MQM بديلاً أكثر تفصيلاً وقابلية للتطبيق. يقسم أخطاء الترجمة إلى فئ