Översättningsnoggrannhetsmått: Förklarat

Översättningsnoggrannhetsmått hjälper till att utvärdera hur väl maskinöversättningar matchar människoskapade referenser. Dessa verktyg är avgörande för att bedöma översättningskvalitet, särskilt när man hanterar storskaliga projekt eller innehåll med höga insatser. Mått faller in i tre kategorier:

- Strängbaserade mått: BLEU, METEOR och TER fokuserar på ord- eller teckenöverlapning.

- Neurala mått: COMET och BERTScore analyserar semantisk likhet med hjälp av AI-modeller.

- Mänskliga utvärderingar: Direkta bedömningar som MQM fokuserar på adekvat och flytande.

Viktiga slutsatser:

- BLEU: Snabb och enkel men kämpar med synonymer och djupare betydelse.

- METEOR: Tar hänsyn till synonymer och språkliga nyanser; bättre för litterära verk.

- TER: Mäter redigeringsinsats men ignorerar semantisk kvalitet.

- COMET & BERTScore: Avancerade AI-modeller som överensstämmer väl med mänsklig bedömning, bra för nyanserade texter.

För bokövesättningar säkerställer kombinationen av automatiserade verktyg med mänskliga utvärderingar noggrannhet och bevarar den ursprungliga stilen. Plattformar som BookTranslator.ai använder denna hybridmetod för att leverera tillförlitliga resultat på över 99 språk.

Vanliga översättningsnoggrannnhetsmått

BLEU-poäng

BLEU (Bilingual Evaluation Understudy) introducerades 2002 och är fortfarande ett populärt mått för att bedöma maskinöversättning [4]. Det fungerar genom att jämföra n-gram-precision, vilket innebär att analysera hur ordsekvenser i maskinens utdata överensstämmer med referensöversättningar. BLEU-poäng sträcker sig från 0 till 1, där högre siffror signalerar bättre kvalitet. Dess största styrka? Hastighet och enkelhet - BLEU kan bearbeta tusentals översättningar snabbt, vilket gör det mycket praktiskt. Denna effektivitet gav det till och med NAACL 2018 Test-of-Time-priset.

Som Papineni et al. förklarade: "Huvudidén är att använda ett vägt genomsnitt av n-gram-matchningar med variabel längd mellan systemets översättning och en uppsättning mänskliga referensöversättningar" [4].

BLEU har dock en anmärkningsvärd begränsning: det prioriterar exakta ordmatchningar. Det betyder att det kan undervärderas översättningar som förmedlar samma betydelse men använder olika ordalydelse. För att åtgärda detta syftar mått som METEOR på att fånga språkliga nyanser.

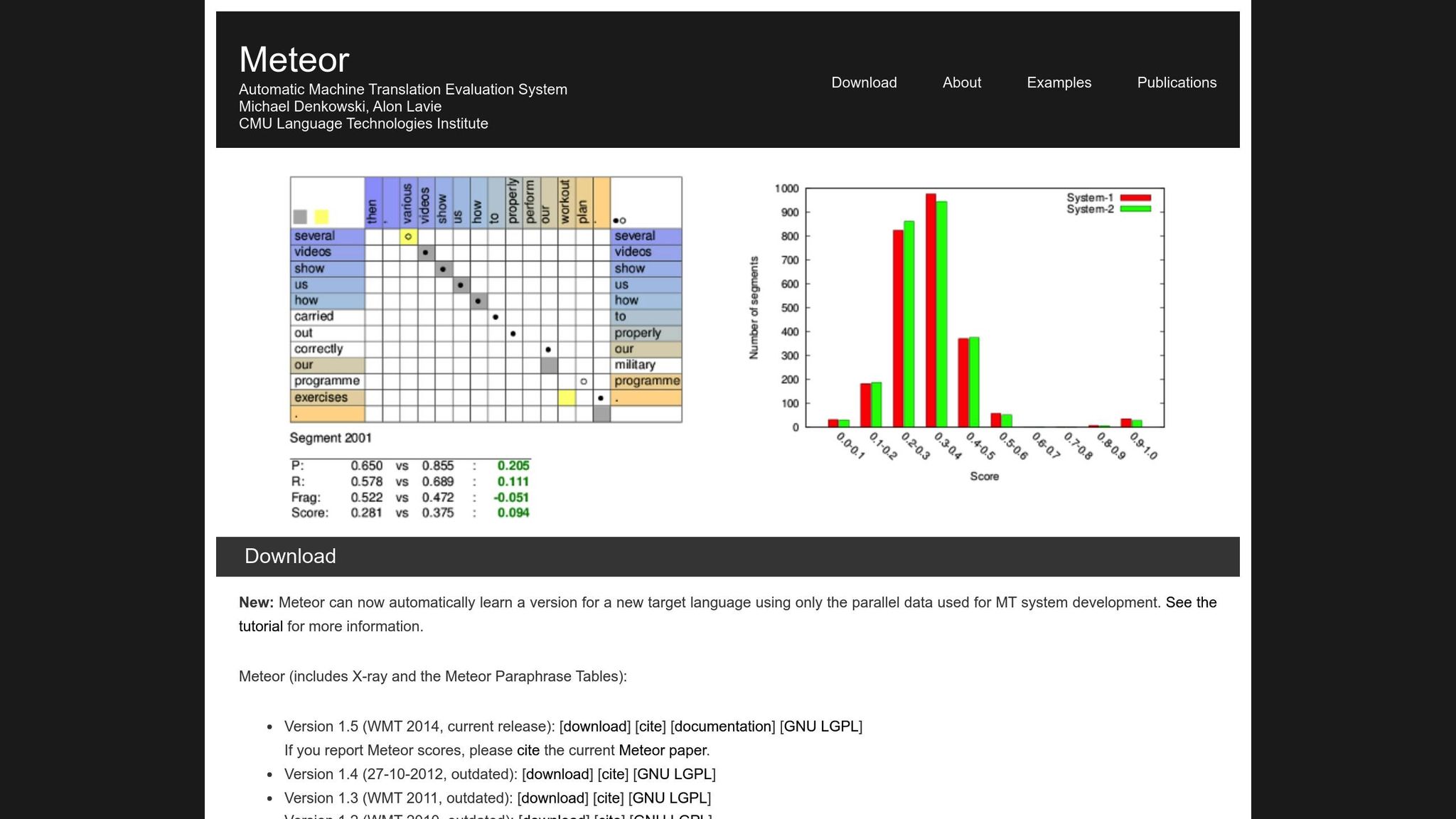

METEOR-mått

METEOR (Metric for Evaluation of Translation with Explicit ORdering) förbättrar BLEU genom att ta hänsyn till precision, återkallelse, synonymer, stamning och ordningsstraff [1]. Det hanterar variationer som "running" kontra "ran" eller "happy" kontra "joyful", vilket gör det bättre lämpat för översättningar där betydelse är det viktigaste. Under NIST MetricsMaTr10-utmaningen uppnådde METEOR‑next‑rank till exempel en Spearmans rho-korrelation på 0,92 med mänskliga bedömningar på systemnivå och 0,84 på dokumentnivå [1].

Det sagt kommer METEOR med sina egna utmaningar. Det kräver ytterligare resurser, såsom synonymdatabaser och stammningsalgoritmer, vilket ökar dess beräkningsbelastning. Ändå ger det ofta en mer nyanserad och tillförlitlig utvärdering, särskilt för att fånga semantisk noggrannhet.

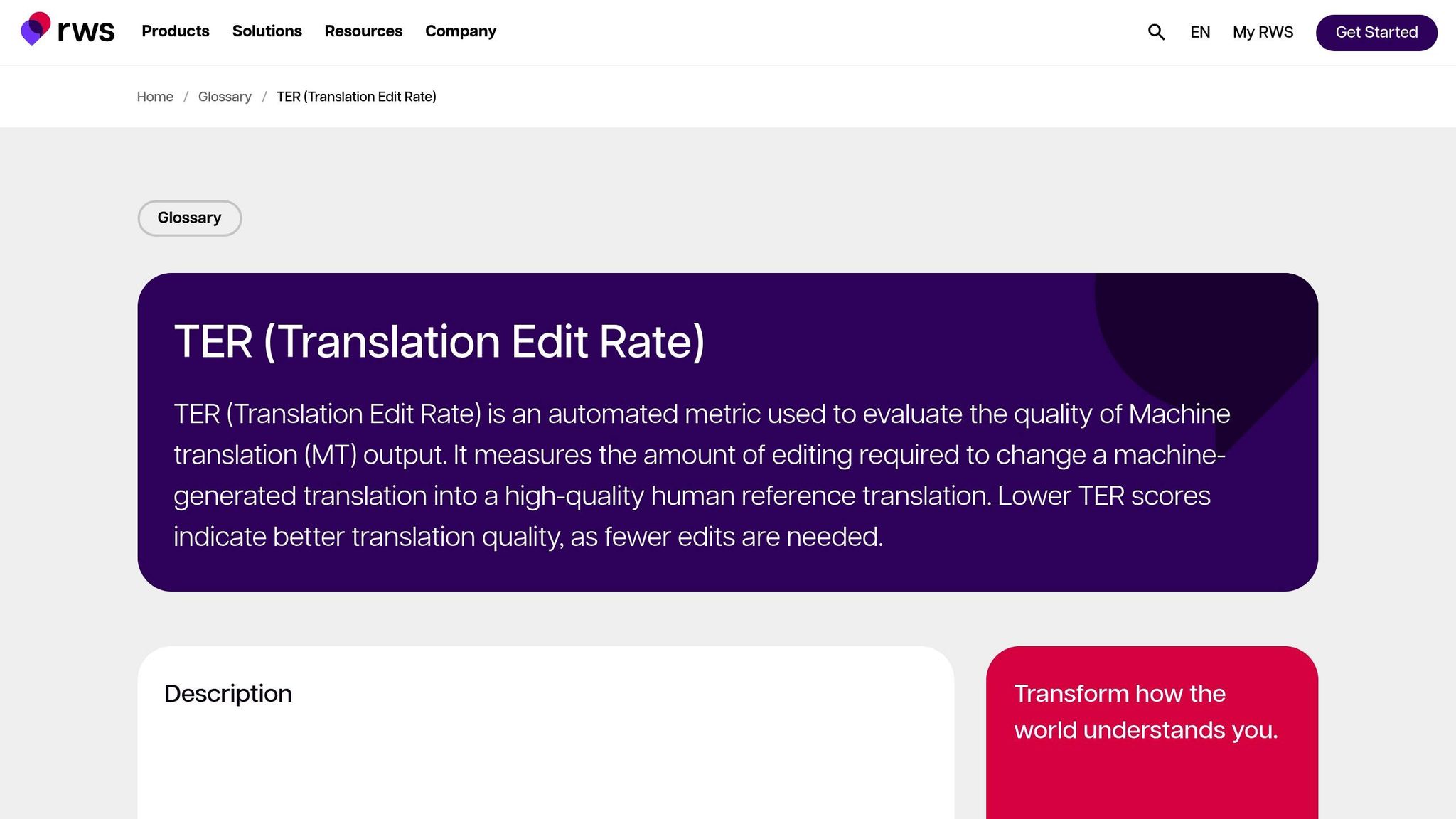

Översättningsredigeringshastighet (TER)

TER utvärderar översättningskvalitet genom att beräkna antalet redigeringar - infogningar, borttagningar, ersättningar och skift - som behövs för att omvandla maskinutdata till referensen. Detta gör det särskilt användbart för att mäta den redigeringinsats som krävs för att anpassa utdata till det önskade resultatet. I MetricsMaTr10-utvärderingarna visade TER-v0.7.25 en systemniväkorrelation på 0,89 med mänskliga bedömningar av semantisk adekvat, medan TERp visade en segmentnivåkorrelation på 0,68 [1].

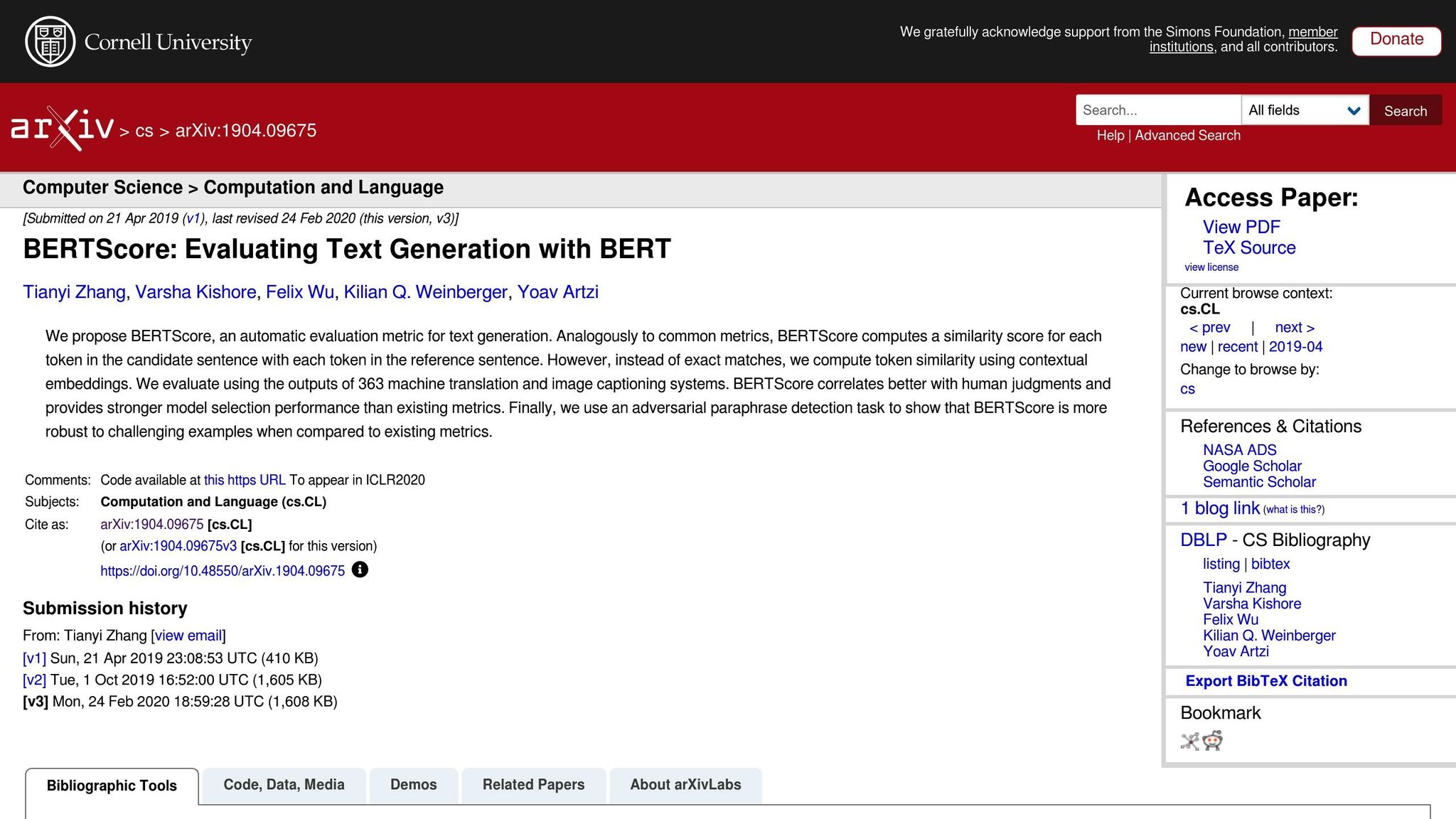

Neurala mått: BERTScore, COMET och GEMBA

Neurala mått tar översättningsutvärderingen till nästa nivå genom att fokusera på semantisk analys snarare än exakta ordmatchningar. Här är en snabb sammanfattning:

- BERTScore: Använder kontextuella inbäddningar för att mäta likhet mellan översättningar.

- COMET: Integrerar källtext, hypotes och referensöversättningar i ett neuralt ramverk tränat på mänskliga anteckningar. Det har uppnått några av de högsta korrelationerna med mänskliga kvalitetsbedömningar [5].

- GEMBA: Utnyttjar stora språkmodeller för nollskotts kvalitetsuppskattning, vilket ger en närmare approximation till mänsklig utvärdering.

Även om dessa mått är kraftfulla kommer de med avvägningar. Till skillnad från BLEU och TER, som kan köras på standard-CPU:er på millisekunder, kräver neurala mått som BERTScore och COMET ofta GPU-acceleration för att effektivt hantera stora dataset. GEMBA kan i synnerhet innebära höga API-kostnader och potentiella förspeglade från stora språkmodeller, vilket gör det mindre tillgängligt för vissa användare.

Automatiska mått för utvärdering av MT-system

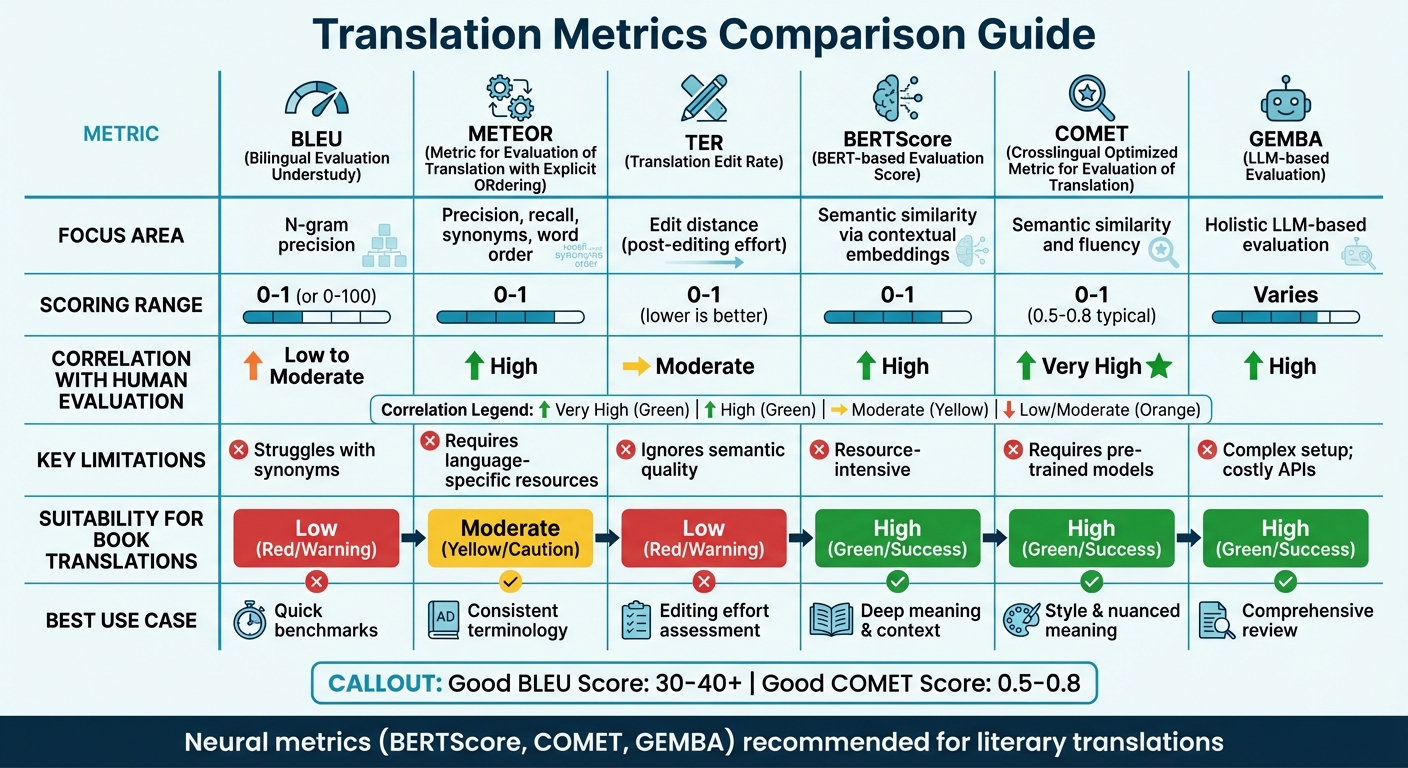

Jämföra översättningsmått

Jämförelse av översättningsnoggrannnhetsmått: BLEU, METEOR, TER, BERTScore, COMET och GEMBA

Måttjämförningstabell

Att välja rätt översättningsmått beror ofta på fokus för din utvärdering och de resurser du har tillgängliga. Traditionella mått som BLEU är snabba och kräver minimala resurser men kämpar med att fånga djupare semantisk betydelse. Å andra sidan utmärker sig neurala mått för att förstå sammanhang och betydelse men kräver mer beräkningskraft.

Nylig forskning föreslår att man bör gå bort från överlappsbaserade mått. Till exempel rekommenderar WMT22-fynd att man överger mått som BLEU till förmån för neurala metoder [6]. Studien belyser att överlappmått som BLEU, spBLEU och chrF dåligt korrelerar med mänskliga expertbedömningar.

Här är en snabb jämförelse av viktiga översättningsmått, som täcker deras fokusområden, poängsättningsmetoder, korrelation med mänsklig utvärdering, begränsningar och lämplighet för bokövesättningar:

| Mått | Fokusområde | Poängintervall | Korrelation med mänsklig utvärdering | Begränsningar | Lämplighet för bokövesättningar |

|---|---|---|---|---|---|

| BLEU | N-gram-precision | 0 till 1 (eller 0-100) | Låg till måttlig | Kämpar med synonymer [7][8] | Låg; saknar förmåga att fånga litterär stil |

| METEOR | Precision, återkallelse, synonymer, ordordning | 0 till 1 | Hög | Kräver språkspecifika resurser [7] | Måttlig; användbar för konsekvent terminologi |

| TER | Redigeringsavstånd (efterredigeringsinsats) | 0 till 1 (lägre är bättre) | Måttlig | Ignorerar semantisk kvalitet [7] | Låg; fokuserar på mekanik, inte "röst" |

| BERTScore | Semantisk likhet via kontextuella inbäddningar | 0 till 1 | Hög | Resursintensiv [7] | Hög; fångar djupare betydelse och sammanhang |

| COMET | Semantisk likhet och flytande | 0 till 1 (0,5-0,8 typiskt) | Mycket hög | Kräver förtränade modeller [7][8] | Hög; bevarar stil och nyanserad betydelse |

| GEMBA | Holistisk LLM-baserad utvärdering | Varierar | Hög | Komplex installation; dyra API:er [7] | Hög; erbjuder en "människolik" omfattande granskning |

Denna tabell understryker hur olika mått överensstämmer med specifika översättningsbehov. För tekniska översättningar ger mått som BLEU och TER snabba, grundläggande riktmärken. Men för litterära översättningar - där stil, ton och nyanserad betydelse är kritiska - presterar neurala mått som BERTScore och COMET mycket bättre. Dessa verktyg är särskilt skickliga på att fånga djupet och konstnärligheten i litterära texter, vilket traditionella mått ofta förbiser [7].

Till exempel, plattformar som BookTranslator.ai, som syftar till att balansera effektivitet och kvalitet, gynnas betydligt av neurala mått. Verktyg som BERTScore och COMET säkerställer att både semantisk noggrannhet och litterär stil bevaras.

För att sätta saker i perspektiv ligger en "bra" BLEU-poäng typiskt mellan 30 och 40, med poäng över 40 som anses starka, och allt över 50 indikerar högkvalitativ översättning [8]. För COMET sträcker sig poäng generellt från 0,5 till 0,8, med värden närmare 1,0 som återspeglar nästan mänsklig översättningskvalitet [8]. Neurala mått presterar inte bara konsekvent över olika texttyper utan anpassas också bättre till varierande sammanhang jämfört med domänkänsliga mått som BLEU [6].

sbb-itb-0c0385d

Mänskliga utvärderingsmetoder

Automatiserade mått kan erbjuda hastighet och konsekvens, men de missar ofta de subtila detaljer som definierar översättningskvalitet. Det är där mänsklig utvärdering kommer in som guldstandarden[2]. Även om det är långsammare och dyrare ger mänsklig utvärdering möjligheten att avslöja de djupare orsakerna bakom kvalitetsproblem - saker som mått som BLEU eller COMET helt enkelt inte kan identifiera[9].

Det finns två huvudsakliga tillvägagångssätt för mänsklig utvärdering. Det ena är Directly Expressed Judgment (DEJ), där översättningar bedöms på skalor som flytande och adekvat. Det andra involverar icke-DEJ-metoder, som fokuserar på att upptäcka och kategorisera specifika fel, ofta med ramverk som MQM[12]. Medan analytiska metoder bryter ned enskilda fel och deras allvarlighetsgrad, tittar holistiska metoder på den övergripande kvaliteten. Tillsammans utgör dessa metoder grunden för ramverk som MQM.

MQM (flerdimensionella kvalitetsmått)

När automatiserade verktyg inte räcker erbjuder MQM ett mer detaljerat och användbart alternativ. Det bryter ned översättningsfel i kategorier som Noggrannhet, Flytande, Terminologi, Språkkonventioner och Design/Markup, snarare än att sammanfatta kvalitet med ett enda nummer[18, 17].

"Automatiserade mått ger däremot vanligtvis bara ett nummer utan indikation på hur man kan förbättra resultaten."

– MQM-kommittén[10]

Fel bedöms efter allvarlighetsgrad: Neutral (flaggad men acceptabel, ingen straff), Minor (något märkbar, straffvikt på 1), Major (påverkar förståelse, straffvikt på 5) och Critical (gör texten oanvändbar, straffvikt på 25)[11]. För kritiska översättningar, som juridiska dokument, kan passeringströsklar sättas så högt som 99,5 på en rå poängskala[11].

Det som gör MQM särskilt användbar är dess förmåga att peka på specifika problemområden. Till exempel, om en litterär översättning får dåligt betyg, kan MQM avslöja om problemet ligger i opretentiös formulering eller inkonsekvent terminologi. Denna nivå av detalj är särskilt värdefull för plattformar som BookTranslator.ai, där det är väsentligt att fånga både betydelse och litterär stil.

Adekvat- och flytande poängsättning

Byggt på strukturerade ramverk som MQM fokuserar utvärderare också på två nyckelaspekter av översättningskvalitet: adekvat och flytande. Adekvat mäter hur väl översättningen förmedlar betydelsen av källtexten, medan flytande utvärderar hur naturlig och läsbar den är för modersmålstalare. Dessa aspekter bedöms ofta på femgradig skalor[9].

Att balansera dessa två dimensioner kan vara knepigt, särskilt i litterära översättningar. Att bevara den ursprungliga författarens röst samtidigt som man säkerställer att texten läses smidigt på målspråket kräver noggrann uppmärksamhet.

För att förfina denna process använder utvärderare Direct Assessment (DA), som poängsätter översättningar i enspråkiga, tvåspråkiga eller referensbaserade format[9]. Scalar Quality Metric (SQM) tar detta ett steg längre med en sjugradig skala, vilket gör det möjligt för bedömare att utvärdera enskilda segment inom ramen för hela dokumentet. För böcker är denna kontextuella fokus kritisk - kvaliteten beror ofta på hur väl ett kapitel utvecklar karaktärer eller upprätthåller handlingskonsekvens.

Använda mått för bokövesättning

Att översätta böcker är en unik utmaning. Till skillnad från instruktionsmanual eller marknadsföringsmaterial kräver böcker en balans mellan semantisk noggrannhet - att säkerställa att betydelsen är korrekt - och stilistisk bevarelse - att upprätthålla författarens röst och ton. Att utvärdera bokövesättningar kräver ett skräddarsytt tillvägagångssätt, med mått valda för att passa den specifika typen av innehål som översätts.

Tekniska kontra litterära översättningar

Inte alla bokövesättningar har samma krav. Tekniska texter, såsom akademiska eller instruktionsmaterial, prioriterar precision och konsekvens. För dessa är mått som TER (Translation Edit Rate) särskilt effektiva, eftersom de mäter mängden redigering som behövs för att perfekt översättningen.

Litterära verk är däremot en annan historia. Romaner, memoarer och liknande genrer förlitar sig starkt på berättarflöde och emotionell resonans. I dessa fall utmärker sig METEOR eftersom det tar hänsyn till synonymer och subtila semantiska skillnader, och uppnår korrelationer med mänskliga utvärderingar så höga som 0,92 på systemnivå [1]. Även om BLEU kan ge ett snabbt utgångsvärde, missar det ofta de djupare nyanser som definierar högkvalitativ litterär översättning.

Kombinera automatisk och mänsklig utvärdering

Med tanke på de varierande kraven på bokövesättning fungerar ett hybridvärderingsförhållningssätt bäst. Neurala mått som COMET och BERTScore erbjuder ett snabbt sätt att mäta översättningskvalitet och