अनुवाद सटीकता मेट्रिक्स: व्याख्या

अनुवाद सटीकता मेट्रिक्स यह मूल्यांकन करने में मदद करती हैं कि मशीन अनुवाद मानव-निर्मित संदर्भों से कितनी अच्छी तरह मेल खाते हैं। ये उपकरण अनुवाद गुणवत्ता का आकलन करने के लिए महत्वपूर्ण हैं, विशेष रूप से बड़े पैमाने की परियोजनाओं या उच्च-दांव सामग्री को संभालते समय। मेट्रिक्स तीन श्रेणियों में विभाजित होती हैं:

- स्ट्रिंग-आधारित मेट्रिक्स: BLEU, METEOR, और TER शब्द या वर्ण ओवरलैप पर ध्यान केंद्रित करते हैं।

- तंत्रिका-आधारित मेट्रिक्स: COMET और BERTScore AI मॉडल का उपयोग करके शब्दार्थ समानता का विश्लेषण करते हैं।

- मानव मूल्यांकन: MQM जैसे प्रत्यक्ष आकलन पर्याप्तता और प्रवाह पर ध्यान केंद्रित करते हैं।

मुख्य बातें:

- BLEU: तेज़ और सरल लेकिन समानार्थी शब्दों और गहरे अर्थ के साथ संघर्ष करता है।

- METEOR: समानार्थी शब्दों और भाषाई बारीकियों को ध्यान में रखता है; साहित्यिक कार्यों के लिए बेहतर।

- TER: संपादन प्रयास को मापता है लेकिन शब्दार्थ गुणवत्ता को अनदेखा करता है।

- COMET & BERTScore: उन्नत AI मॉडल जो मानव निर्णय के साथ निकटता से संरेखित होते हैं, सूक्ष्म पाठों के लिए बेहतरीन।

पुस्तक अनुवादों के लिए, स्वचालित उपकरणों को मानव मूल्यांकन के साथ जोड़ने से सटीकता सुनिश्चित होती है और मूल शैली संरक्षित रहती है। BookTranslator.ai जैसे प्लेटफॉर्म 99 से अधिक भाषाओं में विश्वसनीय परिणाम प्रदान करने के लिए इस हाइब्रिड दृष्टिकोण का उपयोग करते हैं।

सामान्य अनुवाद सटीकता मेट्रिक्स

BLEU स्कोर

2002 में पेश किया गया, BLEU (द्विभाषी मूल्यांकन अंडरस्टडी) मशीन अनुवाद का आकलन करने के लिए एक पसंदीदा मेट्रिक बना हुआ है [4]। यह n-ग्राम सटीकता की तुलना करके काम करता है, जिसका अर्थ है कि मशीन के आउटपुट में शब्दों के अनुक्रमों का विश्लेषण करना कि वे संदर्भ अनुवादों के साथ कैसे संरेखित होते हैं। BLEU स्कोर 0 से 1 तक होता है, उच्च संख्या बेहतर गुणवत्ता का संकेत देती है। इसकी सबसे बड़ी शक्ति? गति और सरलता - BLEU हजारों अनुवादों को तेजी से संसाधित कर सकता है, जिससे यह अत्यधिक व्यावहारिक है। इस दक्षता ने इसे NAACL 2018 टेस्ट-ऑफ-टाइम पुरस्कार भी दिलवाया।

जैसा कि Papineni et al. ने समझाया, "मुख्य विचार सिस्टम के अनुवाद और मानव संदर्भ अनुवादों के एक सेट के बीच चर लंबाई n-ग्राम मेल का भारित औसत उपयोग करना है" [4]।

हालांकि, BLEU की एक उल्लेखनीय सीमा है: यह सटीक शब्द मेल को प्राथमिकता देता है। इसका मतलब है कि यह ऐसे अनुवादों को कम महत्व दे सकता है जो एक ही अर्थ व्यक्त करते हैं लेकिन विभिन्न शब्दावली का उपयोग करते हैं। इसे संबोधित करने के लिए, METEOR जैसी मेट्रिक्स भाषाई बारीकियों को पकड़ने का लक्ष्य रखती हैं।

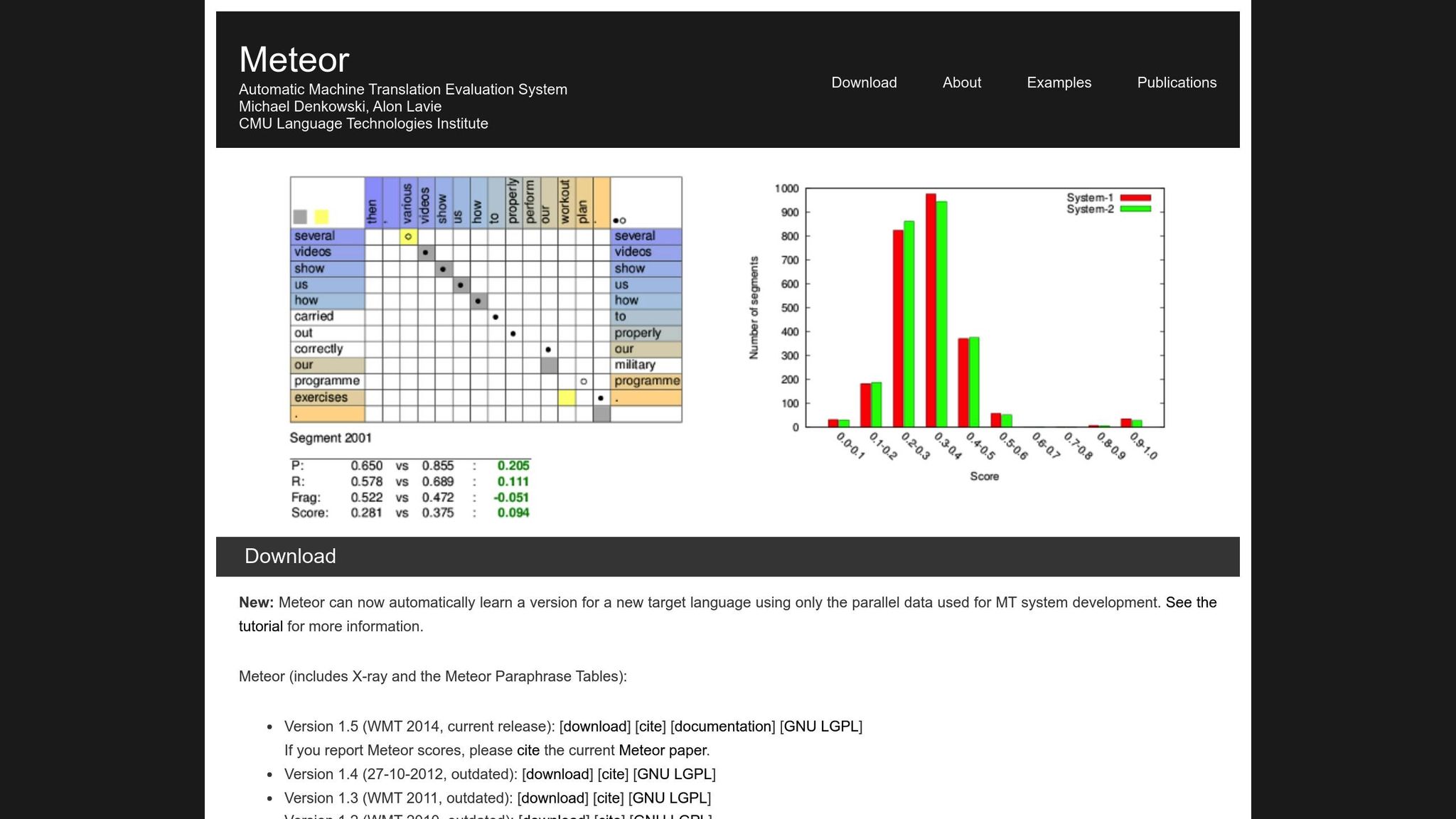

METEOR मेट्रिक

METEOR (स्पष्ट क्रम के साथ अनुवाद मूल्यांकन के लिए मेट्रिक) सटीकता, रिकॉल, समानार्थी शब्द, स्टेमिंग, और शब्द क्रम दंड को ध्यान में रखकर BLEU में सुधार करता है [1]। यह "दौड़ना" बनाम "दौड़ा" या "खुश" बनाम "आनंदित" जैसी भिन्नताओं को संभालता है, जिससे यह उन अनुवादों के लिए बेहतर उपयुक्त है जहां अर्थ सबसे महत्वपूर्ण है। उदाहरण के लिए, NIST MetricsMaTr10 चुनौती के दौरान, METEOR‑next‑rank ने सिस्टम स्तर पर 0.92 और दस्तावेज़ स्तर पर 0.84 का Spearman's rho सहसंबंध प्राप्त किया [1]।

कहा जाता है कि METEOR की अपनी चुनौतियाँ हैं। इसके लिए अतिरिक्त संसाधनों की आवश्यकता होती है, जैसे समानार्थी डेटाबेस और स्टेमिंग एल्गोरिदम, जो इसके कम्प्यूटेशनल भार को बढ़ाते हैं। फिर भी, यह अक्सर अधिक सूक्ष्म और विश्वसनीय मूल्यांकन प्रदान करता है, विशेष रूप से शब्दार्थ सटीकता को पकड़ने के लिए।

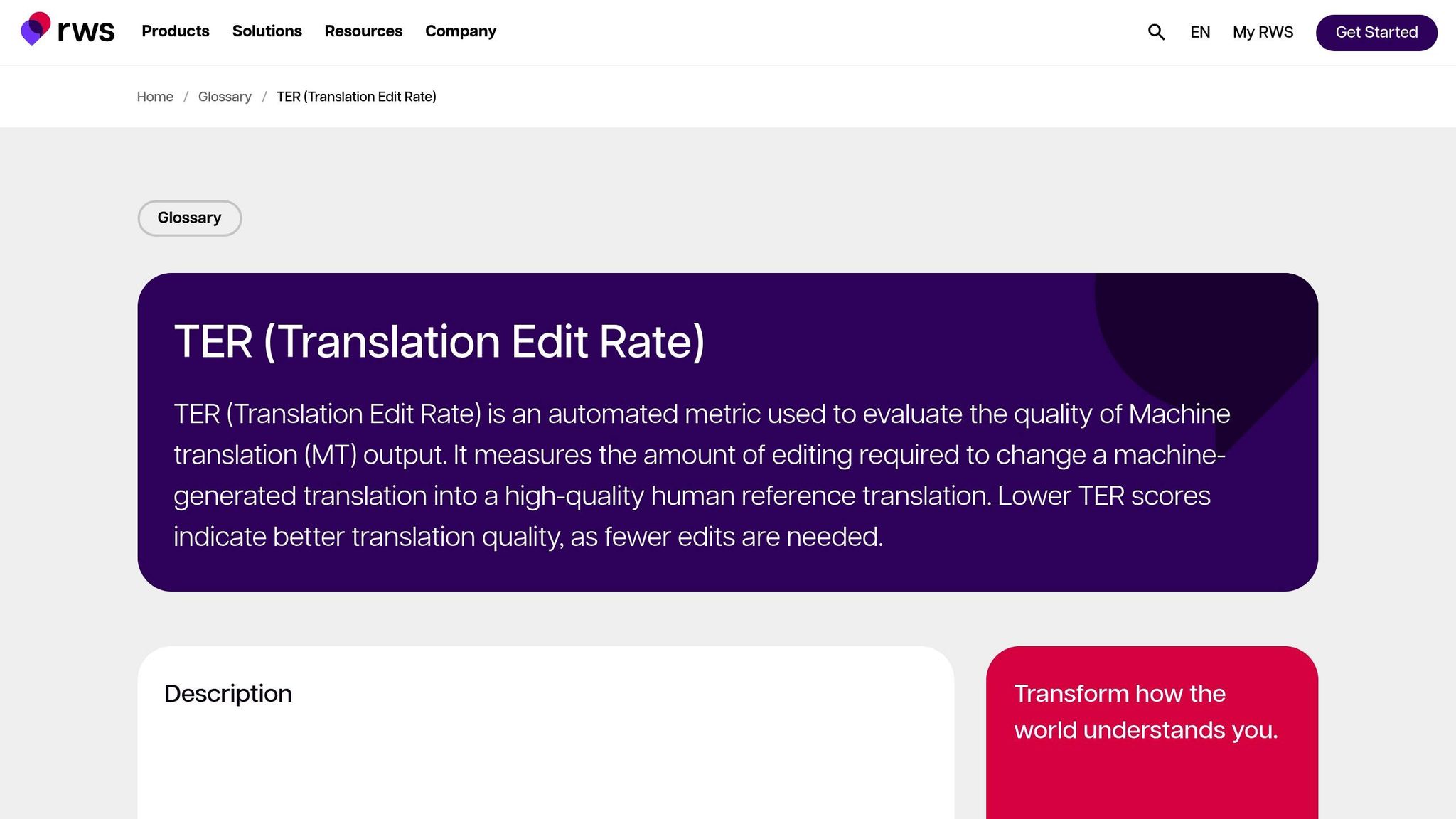

अनुवाद संपादन दर (TER)

TER मशीन आउटपुट को संदर्भ में बदलने के लिए आवश्यक संपादन - सम्मिलन, विलोपन, प्रतिस्थापन, और शिफ्ट - की संख्या की गणना करके अनुवाद गुणवत्ता का मूल्यांकन करता है। यह आउटपुट को वांछित परिणाम के साथ संरेखित करने के लिए आवश्यक संपादन प्रयास को मापने के लिए विशेष रूप से उपयोगी है। MetricsMaTr10 मूल्यांकन में, TER-v0.7.25 ने शब्दार्थ पर्याप्तता के मानव आकलन के साथ 0.89 का सिस्टम-स्तरीय सहसंबंध प्रदर्शित किया, जबकि TERp ने 0.68 का खंड-स्तरीय सहसंबंध दिखाया [1]।

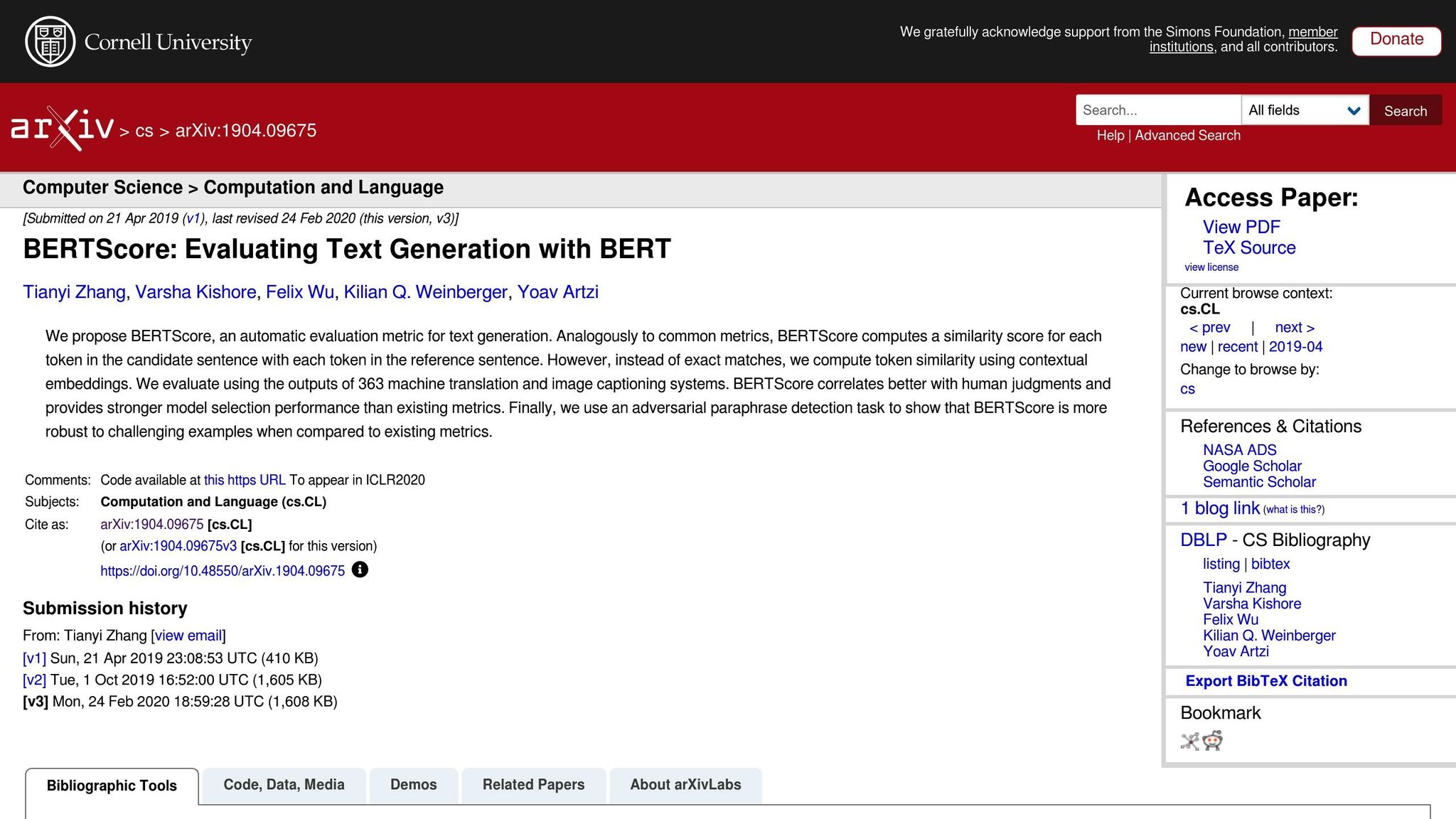

तंत्रिका-आधारित मेट्रिक्स: BERTScore, COMET, और GEMBA

तंत्रिका-आधारित मेट्रिक्स सटीक शब्द मेल के बजाय शब्दार्थ विश्लेषण पर ध्यान केंद्रित करके अनुवाद मूल्यांकन को अगले स्तर पर ले जाती हैं। यहाँ एक त्वरित विवरण दिया गया है:

- BERTScore: अनुवादों के बीच समानता को मापने के लिए संदर्भपूर्ण एम्बेडिंग का उपयोग करता है।

- COMET: स्रोत पाठ, परिकल्पना, और संदर्भ अनुवादों को मानव एनोटेशन पर प्रशिक्षित एक तंत्रिका ढांचे में एकीकृत करता है। यह मानव गुणवत्ता निर्णयों के साथ कुछ उच्चतम सहसंबंध प्राप्त किया है [5]।

- GEMBA: शून्य-शॉट गुणवत्ता अनुमान के लिए बड़े भाषा मॉडल का लाभ उठाता है, मानव मूल्यांकन के करीब एक सन्निकटन प्रदान करता है।

जबकि ये मेट्रिक्स शक्तिशाली हैं, उनमें ट्रेड-ऑफ हैं। BLEU और TER के विपरीत, जो मिलीसेकंड में मानक CPU पर चल सकते हैं, BERTScore और COMET जैसी तंत्रिका-आधारित मेट्रिक्स को अक्सर बड़े डेटासेट को कुशलतापूर्वक संभालने के लिए GPU त्वरण की आवश्यकता होती है। विशेष रूप से GEMBA, उच्च API लागत और बड़े भाषा मॉडल से संभावित पूर्वाग्रहों को शामिल कर सकता है, जिससे कुछ उपयोगकर्ताओं के लिए यह कम सुलभ हो जाता है।

MT सिस्टम का मूल्यांकन करने के लिए स्वचालित मेट्रिक्स

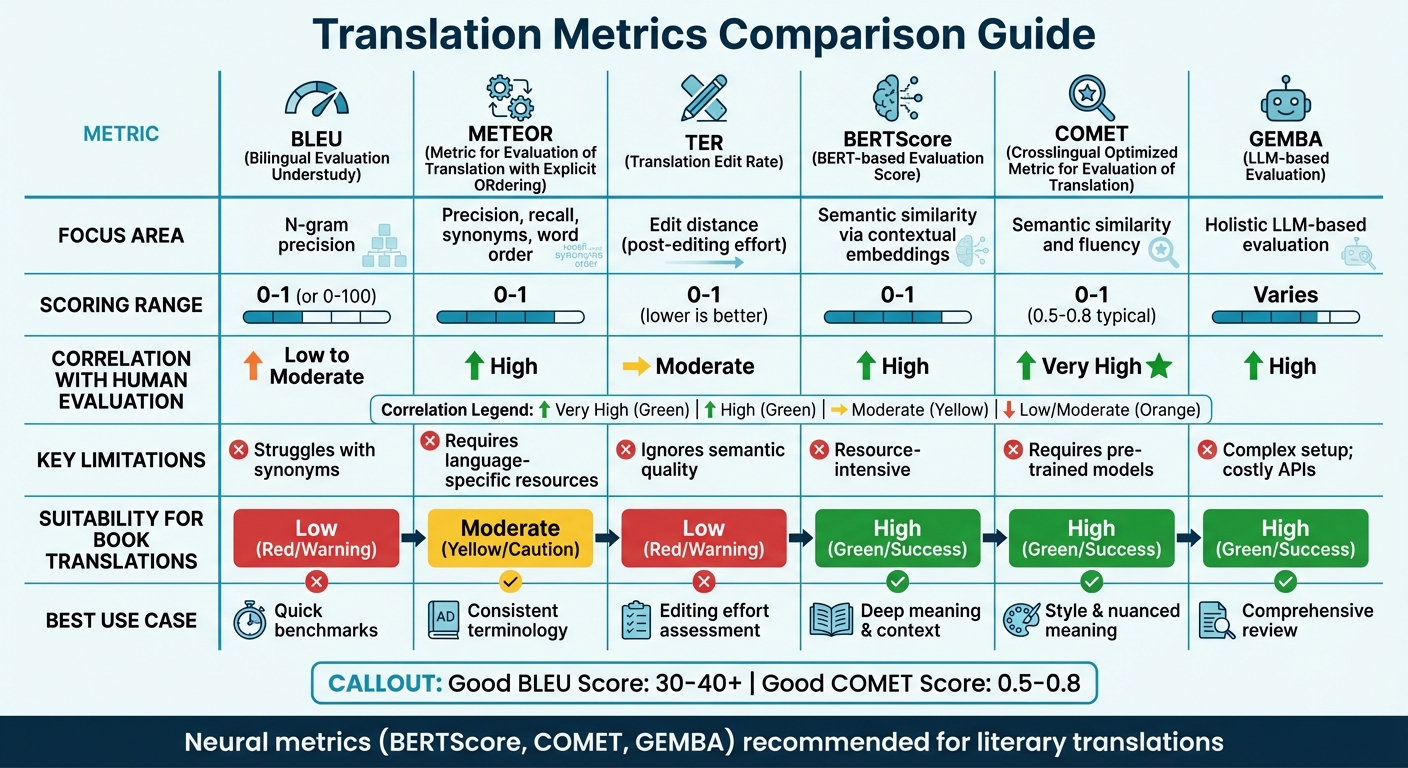

अनुवाद मेट्रिक्स की तुलना

अनुवाद सटीकता मेट्रिक्स तुलना: BLEU, METEOR, TER, BERTScore, COMET, और GEMBA

मेट्रिक तुलना तालिका

सही अनुवाद मेट्रिक चुनना अक्सर आपके मूल्यांकन के फोकस और हाथ में मौजूद संसाधनों पर निर्भर करता है। BLEU जैसी पारंपरिक मेट्रिक्स तेज़ और न्यूनतम संसाधन की आवश्यकता रखती हैं लेकिन गहरे शब्दार्थ अर्थ को पकड़ने में संघर्ष करती हैं। दूसरी ओर, तंत्रिका मेट्रिक्स संदर्भ और अर्थ को समझने में उत्कृष्ट हैं लेकिन अधिक कम्प्यूटेशनल शक्ति की मांग करती हैं।

हाल के शोध ओवरलैप-आधारित मेट्रिक्स से दूर जाने का सुझाव देते हैं। उदाहरण के लिए, WMT22 के निष्कर्ष तंत्रिका दृष्टिकोणों के पक्ष में BLEU जैसी मेट्रिक्स को छोड़ने की सिफारिश करते हैं [6]। अध्ययन में यह उजागर किया गया है कि BLEU, spBLEU, और chrF जैसी ओवरलैप मेट्रिक्स मानव विशेषज्ञ मूल्यांकन के साथ खराब तरीके से संबंधित हैं।

यहाँ मुख्य अनुवाद मेट्रिक्स की एक त्वरित तुलना दी गई है, जो उनके फोकस क्षेत्र, स्कोरिंग विधियों, मानव मूल्यांकन सहसंबंध, सीमाओं, और पुस्तक अनुवादों के लिए उपयुक्तता को कवर करती है:

| मेट्रिक | फोकस क्षेत्र | स्कोरिंग रेंज | मानव मूल्यांकन के साथ सहसंबंध | सीमाएं | पुस्तक अनुवादों के लिए उपयुक्तता |

|---|---|---|---|---|---|

| BLEU | N-ग्राम सटीकता | 0 से 1 (या 0-100) | कम से मध्यम | समानार्थी शब्दों के साथ संघर्ष करता है [7][8] | कम; साहित्यिक शैली को पकड़ने की क्षमता की कमी |

| METEOR | सटीकता, रिकॉल, समानार्थी शब्द, शब्द क्रम | 0 से 1 | उच्च | भाषा-विशिष्ट संसाधनों की आवश्यकता [7] | मध्यम; सुसंगत शब्दावली के लिए उपयोगी |

| TER | संपादन दूरी (संपादन के बाद का प्रयास) | 0 से 1 (कम बेहतर है) | मध्यम | शब्दार्थ गुणवत्ता को अनदेखा करता है [7] | कम; यांत्रिकी पर ध्यान केंद्रित करता है, "कंठस्वर" पर नहीं |

| BERTScore | संदर्भपूर्ण एम्बेडिंग के माध्यम से शब्दार्थ समानता | 0 से 1 | उच्च | संसाधन-गहन [7] | उच्च; गहरे अर्थ और संदर्भ को पकड़ता है |

| COMET | शब्दार्थ समानता और प्रवाह | 0 से 1 (0.5-0.8 विशिष्ट) | बहुत उच्च | पूर्व-प्रशिक्षित मॉडल की आवश्यकता [7][8] | उच्च; शैली और सूक्ष्म अर्थ को संरक्षित करता है |

| GEMBA | समग्र LLM-आधारित मूल्यांकन | भिन्न | उच्च | जटिल सेटअप; महंगे API [7] | उच्च; "मानव-जैसी" व्यापक समीक्षा प्रदान करता है |

यह तालिका यह स्पष्ट करती है कि विभिन्न मेट्रिक्स विशिष्ट अनुवाद आवश्यकताओं के साथ कैसे संरेखित होती हैं। तकनीकी अनुवादों के लिए, BLEU और TER जैसी मेट्रिक्स त्वरित, बुनियादी बेंचमार्क प्रदान करती हैं। हालांकि, साहित्यिक अनुवादों के लिए - जहां शैली, टोन, और सूक्ष्म अर्थ महत्वपूर्ण हैं - BERTScore और COMET जैसी तंत्रिका मेट्रिक्स बहुत बेहतर प्रदर्शन करती हैं। ये उपकरण विशेष रूप से साहित्यिक पाठों की गहराई और कलात्मकता को पकड़ने में निपुण हैं, जो पारंपरिक मेट्रिक्स अक्सर अनदेखा करती हैं [7]।

उदाहरण के लिए, BookTranslator.ai जैसे प्लेटफॉर्म, जो दक्षता और गुणवत्ता को संतुलित करने का लक्ष्य रखते हैं, तंत्रिका मेट्रिक्स से काफी लाभान्वित होते हैं। BERTScore और COMET जैसे उपकरण यह सुनिश्चित करते हैं कि शब्दार्थ सटीकता और साहित्यिक शैली दोनों संरक्षित हों।

बातों को परिप्रेक्ष्य में रखने के लिए, एक "अच्छा" BLEU स्कोर आमतौर पर 30 और 40 के बीच होता है, 40 से ऊपर के स्कोर को मजबूत माना जाता है, और 50 से अधिक कुछ भी उच्च-गुणवत्ता अनुवाद का संकेत देता है [8]। COMET के लिए, स्कोर आमतौर पर 0.5 से 0.8 तक हो